搜索引擎是如何抓取页面的

时间:2022-03-08

作者:北京利美seo

来源:互联网

蜘蛛想要抓取网站的内容的话,就需求有一个入口停止抓取。假设没有入口,他们就无奈抓取网站。因此,网站建成

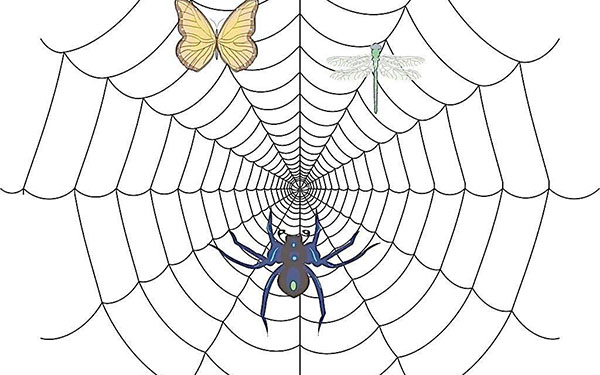

搜查引擎是经过蜘蛛爬虫来抓取和收录网页的。抓取页面内容是搜查引擎工作的首步。了解搜查引擎抓取网页的机制,可能协助蜘蛛和爬虫抓取更多的网页,提高网站的排名。

蜘蛛,也称为网络蜘蛛,是一个程序或脚本,会依据某些规则对网页停止抓取。

蜘蛛想要抓取网站的内容的话,就需求有一个入口停止抓取。假设没有入口,他们就无奈抓取网站。因此,seo优化,网站建成后咱们要给搜查引擎一个进入网站的入口,网络营销,这样蜘蛛就可能追随链接进入网站的每个角落,并且在达到肯定的条件之前不会中止。中止条件的设置通常由工夫或数量决议,链接的数量也可能用来限度蜘蛛的爬行。同时,页面信息的重要性也将决议爬行器能否会检索页面。

在搜查引擎中,一些网站十分受蜘蛛的欢迎,这些网站也将是蜘蛛和爬举动物的起点。普通情况下,这种网站具备肯定的有名性和导航性,十分适宜作为种子网站。因此,在停止网站优化时,可能将本人的网站提交到分类目录中,无利于蜘蛛和爬举动物的爬行。

搜查引擎是如何抓取页面的

网站更新的频率间接影响蜘蛛的爬行频率。假设网站每天定期定量更新,蜘蛛也会在这段工夫内进入网站停止爬虫。

每次蜘蛛爬虫抓取网站内容时,它都会存储内容。假设第二次爬网发现页面与前一次抓取的内容相反,则示意网站未更新。通过长工夫的抓取,蜘蛛爬虫会对网站页面的更新频率有肯定的了解。一些更新不频繁的网站,蜘蛛爬虫也会放弃抓取。假设网站常常更新内容,蜘蛛爬虫就会常常进入网站,从而抓取网站上的新链接,从而提高网站的排名。

因此,在网站优化过程中,应常常更新网站内容,以添加网站被抓取的频率。搜查引擎蜘蛛会在抓取网页后将网页存储在原始数据库中。一段工夫后,搜查引擎将相应地解决原始数据库中的页面。

- 上一篇:优帮云分享正确的SEO排名优化方法

- 下一篇:增加网站外部链接的方法